搞懂这5个模块,你才真的懂AI Agent

【数据猿导读】 构建AI Agent的底层技术全指南,建议收藏!

“构建AI Agent的底层技术全指南,建议收藏!

最近,一大波“AI Agent”项目在朋友圈刷屏,仿佛谁不搞个Agent,就像Web3时期谁不发币,GenAI时期谁不用GPT——都显得“落后于时代”。

从Auto-GPT到Devin,再到MCP、 A2A协作、多角色Agent编排,AI Agent已然成为当前最炽热的技术风口之一。

但热度之下,也有混乱正在蔓延:

很多初创项目把一个加了“工具调用”的prompt,当作Agent系统;

不少企业部署了所谓Agent,结果发现只是“自动填表机器人+LLM问答助手”的拼装体;

一些开发者以为接个大模型、套个API,就构建了一个智能体,却在实际运行中发现系统崩溃、状态丢失、工具失败后“无脑重试”……

AI Agent并不是prompt拼接游戏,也不是LLM的UI封装。它是一种系统工程。

真正的Agent,是具备状态感知、任务分解、上下文记忆、工具交互、行为反馈与自主规划能力的复杂智能系统。

如果说大语言模型是“大脑”,那么一个真正的Agent,还需要“身体”、“感官”、“行动系统”以及“神经网络”。

本篇文章,我们将深入拆解:

·构建一个AI Agent到底需要哪些核心技术能力?

·LLM、Memory、Planner、Tool-use、Reflection之间如何协同构成一个闭环系统?

·MCP、ReAct、A2A等主流架构的异同与适用场景

·当前Agent系统中的四大关键挑战与工程难题

理解Agent的底层逻辑,不只是“会用”,更是“会设计、会评估、会扩展”的关键。尤其对产品人、AI 工程师、决策者来说,只有真正看懂Agent的技术图谱,才谈得上布局未来。

AI Agent架构全景图:

不是“一个大模型”,而是一整套系统

在很多人的认知中,构建一个AI Agent似乎很简单:

“接入一个强大的大语言模型,再加点插件或API调用,就可以自动完成复杂任务。”

但事实是:语言模型只是Agent的“大脑”,真正让它能完成任务、感知环境、保持状态、执行动作的,是整个配套系统。

一个成熟、可运行、可迭代的AI Agent,至少需要以下五大核心模块:

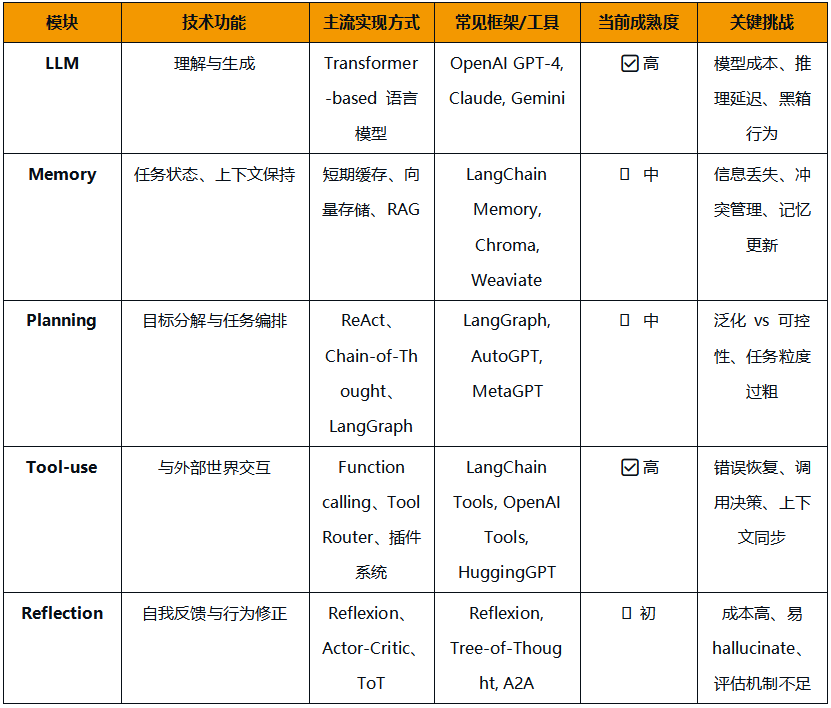

1. LLM(语言模型):Agent的认知中枢

语言模型提供了Agent的“理解力”和“语言生成能力”,也是Agent能进行任务规划、意图识别、自然语言交互的基础。

·功能作用:解析用户意图、生成子任务、撰写输出内容

·典型模型:DeepSeek、通义千问、文心一言、豆包、GPT-5、Claude等

·局限提醒:LLM不具备长期记忆、状态管理和执行能力,它只是Agent的“智囊”,不是“执行者”

2. Memory(记忆系统):上下文感知的延续器

Agent在执行任务时,不能是“一问一答”的短期记忆体,它需要理解历史、跟踪状态、动态适应用户目标。

·功能作用:保存对话上下文、记录任务进度、调用历史经验

·主流实现:短期记忆(Session Buffer)、长期记忆(基于向量库,如 Chroma、Weaviate)、工作记忆(当前步骤+状态+Action历史)

·现实挑战:上下文提取与召回易错乱,信息冗余、冲突、更新策略不统一。

3. Planning(任务规划器):从目标到执行路径

Agent面对一个复杂目标,必须将其拆解成可执行的子任务序列,并动态更新执行计划。

·功能作用:任务分解、流程编排、子目标生成

·常见机制:基于规则(Flowchart、State Machine)、基于模型(ReAct、Chain-of-Thought)、混合型调度器(如 LangGraph)

·重点难点:如何平衡计划的泛化能力与可控性

4. Tool-use(工具调用引擎):Agent的“手脚”

没有工具调用能力的Agent,只能“说”不能“做”。Tool-use机制让Agent能与外部世界交互、执行动作。

·功能作用:执行API、检索信息、读取文件、发送请求等

·关键设计:Action Schema(调用格式定义)、Tool Router(工具选择器)、Error Handling(错误处理、重试、回滚)

·常见实现:LangChain Tools、OpenAI Function calling、HuggingGPT Tool Hub

5. Reflection(自我反思与策略调整):Agent的“元认知能力”

在任务执行失败或结果不佳时,一个强健的Agent应该能审视自身行为,主动修正策略。

·功能作用:评估执行效果、记录失败经验、调整执行路径

·方法代表:Reflexion、Tree-of-Thought(ToT)、Critic Agent+Actor Agent 架构、CoT+ReAct组合策略

·挑战提醒:反思机制往往依赖LLM自我监督,存在hallucination风险

每一层都不可或缺,真正的Agent系统不是“叠prompt”,而是一个状态驱动+意图分解+工具调用+自我学习的闭环系统。

Agent≠模型增强器,而是多模块协同的智能执行体。理解架构,就是理解Agent能力的边界。

要构建一个可运行、可扩展的AI Agent,开发者必须掌握的不只是Prompt编写,更要理解其背后每个模块的功能、技术实现方式、主流方案与当前的成熟度。

下面,我们从五个关键模块出发,逐一拆解其技术原理与行业现状。

技术对比总览表:

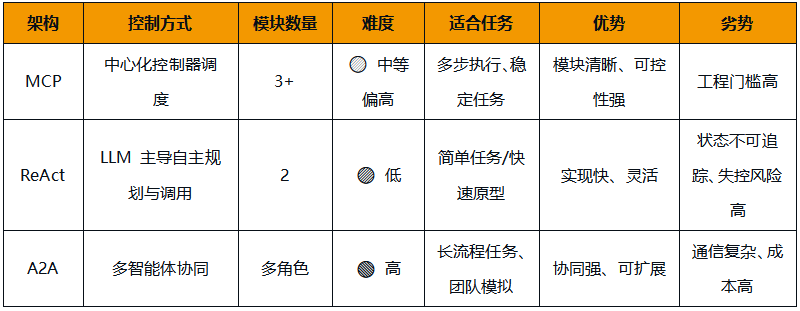

三大关键架构模型对比:MCP/ReAct/A2A

虽然AI Agent的实现可以多种多样,但当前主流的Agent系统,大致可以归入以下三种架构模型:

1.MCP架构(Memory–Controller–Planner)

2.ReAct框架(Reasoning + Acting)

3.A2A架构(Agent-to-Agent协作)

它们在模块拆解、任务控制方式、执行流程与适用场景上,都体现了不同的技术思路与设计哲学。

1. MCP架构:工程化Agent的系统思维代表

全称:Memory+Controller+Planner

架构特点:Memory负责保存上下文与状态信息;Planner负责对用户目标进行子任务规划;Controller作为调度核心,协调各模块及工具调用;可扩展为多Agent协作(如UserAgent+TaskAgent+CriticAgent)。

优势:结构清晰,职责明确,便于模块替换与系统维护;支持多 Agent 组件之间的异步通信;非常适合 B 端企业对稳定性、可控性有较高要求的场景。

局限:开发门槛高,系统复杂度较大;需要大量设计“控制逻辑”和状态传递机制。

适合人群: 有工程能力的团队、希望构建稳定长流程系统的企业用户。

2. ReAct框架:广泛使用的“轻量级智能体原型”

全称:Reasoning+Acting

架构特点:LLM在推理过程中决定要不要调用工具;工具调用后将结果重新反馈给LLM;交替进行“思考(Think)→行动(Act)”的闭环对话流。

示例流程:

User: 查询北京明天的天气→LLM思考:我需要调用weather API→Act: 执行API→Observe: 天气结果→再次Reason+Act...

优势:构建简单,易于理解和实验;高度灵活,几乎所有LLM都能上手。

局限:流程不透明,可控性差;任务状态管理混乱,适合短流程任务或原型验证。

适合人群: 快速验证Agent概念的开发者、独立开发者、AI Hackathon团队。

3. A2A架构:从“单智能体”到“多智能协作”的演化路径

全称: Agent-to-Agent

架构特点:多个具备不同职责的Agent联合组成一个“任务团队”;每个Agent可以独立决策,也可以协商任务;类似现实世界的“协作组织模型”。

举例角色:

·PM Agent:负责拆解任务

·Dev Agent:负责编写代码

·QA Agent:负责验证和测试

·Critic Agent:进行最终审查与评估

优势:高度模块化,适合复杂任务协作;更接近现实组织结构,有利于人机混合工作流整合。

局限:调度难度极高,Agent间通信协议尚未统一;容易出现循环协商、状态漂移、响应延迟等问题;成本高,Agent数量多意味着更多LLM调用开销。

适合人群: 对多角色智能体协同有实际需求的场景(如代码生成、项目管理、仿真)。

对比总结:

不同架构没有绝对优劣,关键在于你的目标是:轻量实验?工程部署?还是智能协作?对大多数项目而言,从ReAct起步、向MCP过渡、最终引入A2A模型,是当前最具现实性的演进路径。

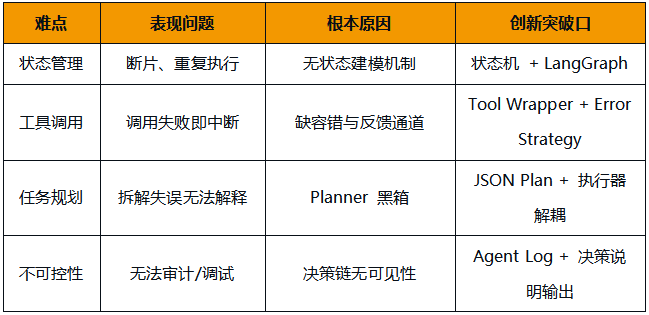

AI Agent架构设计的四个难点

(也是创新机会)

很多人以为AI Agent的难点只是“模型够不够强”。

但现实是,真正拉开Agent能力差距的,不是大脑,而是系统工程。

哪怕你用了最强的GPT-4o或Claude 3,如果下面这几个问题解决不了,Agent依然会“跑偏、跑断、跑废”。

以下是当前Agent架构中最核心的四个工程难题:

1. 状态管理困难:Agent不知道自己“做到哪一步了”

问题现象:Agent执行多步任务时,经常“断片”或重复同一操作;对“上一步结果”的引用依赖LLM记忆,极易错误;缺乏统一状态描述方式,流程一旦中断就无法恢复。

本质挑战:多轮任务的“中间状态”在系统中没有结构化表达;大模型没有显式的任务感知机制,只靠上下文拼接。

潜在解决方向:引入状态机(State Machine)或有向图(DAG)进行流程建模;结合LangGraph等框架,实现任务节点与状态显式映射。

2.工具调用的鲁棒性差:一旦失败,Agent无法“补救”

问题现象:API出错后Agent不知所措,要么死循环重试,要么放弃任务;多工具组合调用后缺少统一反馈机制;工具响应格式微变,就可能导致整个链路崩溃。

本质挑战:当前Agent缺乏工具调用的异常感知机制和容错策略;没有标准化的Action Schema和异常捕捉框架。

潜在解决方向:类似“Tool Result Handler”的模块独立封装;构建Tool Wrapper,为每个工具提供error+fallback策略;Agent具备“判断是否继续”的元认知能力(如验证函数、CriticAgent)。

3.计划模块依赖黑箱模型:可控性与调试性差

问题现象:Agent的任务分解高度依赖语言模型输出;很难验证拆分是否合理、是否高效;出现计划错误时,开发者无法追踪“哪里出问题”。

本质挑战:缺乏一种中间表示语言(Intermediate Planning DSL),用于计划与执行解耦;Planner与Executor强耦合,导致系统不可测试。

潜在解决方向:模型生成JSON Plan→Plan解释器执行(LangGraph、MetaGPT的方式);引入可视化任务流(如Flowchart DSL、Node Execution Tree)提高可解释性。

4.可控性和透明性差:Agent做了什么,你不知道

问题现象:Agent调用了哪些工具、使用了哪些数据、基于什么理由采取某种行为——全在“黑箱”里;企业无法审核Agent行为路径,存在合规和安全隐患;Agent的输出结果难以复盘、难以定位问题。

本质挑战:当前Agent缺乏“行为日志+决策说明”的双重记录机制;决策链路完全依赖LLM内部生成,开发者难以干预。

潜在解决方向:构建Agent Execution Log:记录每次Act、Tool-call、Output;增加“Why did I do this ”机制:由LLM输出简要决策理由;面向企业推出可审计型Agent系统(Audit-friendly Agent)。

AI Agent架构难点vs解决方向

真正构建Agent,不是调大参数或拼API,而是面对这些“系统级痛点”,用工程设计一一攻克。

未来属于“懂架构”的Agent工匠

AI Agent的热潮背后,其实并不是一场“模型竞赛”,而是一场架构能力的比拼。

从Auto-GPT到Devin,我们看到的不是Prompt工程的胜利,而是系统性设计思维的回归:

·谁能稳定管理任务状态;

·谁能优雅调度工具与模型;

·谁能实现结构清晰、易维护、可审计的执行闭环;

·谁就能在这场智能代理的技术革命中站稳脚跟。

语言模型会越来越强,但不会帮你搭系统。

Agent架构,是下一代AI应用的核心战场。能否理解“Memory–Planning–Tool-use–Reflection”的协同逻辑,能否构建“透明、可控、可拓展”的任务系统,决定了一个团队是否真正具备打造Agent应用的核心竞争力。

给不同角色的建议:

·开发者:你的核心竞争力将不再是prompt写得好,而是有没有能力抽象、建模、调度与约束一个复杂系统。

·产品经理:不要幻想Agent是“万能解决方案”,你的任务是定义Agent和人的角色边界,设计好交互模式。

·技术决策者:别只看demo,要看系统架构的稳定性、扩展性和落地的复杂度。真正能部署的Agent,不一定是最“聪明”的,而是最“稳妥”的。

AI Agent并不是一个产品,而是一种新软件形态。它不是更强的机器人,而是更复杂的“数字个体”。它的难点,不在于想象力,而在于工程能力。所以未来属于那些既懂AI,又懂系统架构的“Agent工匠”。

来源:数据猿

刷新相关文章

我要评论

不容错过的资讯

大家都在搜