从同一起点到平行未来:中美大数据产业的十年分岔路

原创 珞珈山人 | 2025-11-11 22:27

【数据猿导读】 十几年前,当中美两国的工程师们都在热烈讨论Hadoop、Spark和开源社区时,他们仿佛站在同一个新大陆的海岸线上,共享着同一套工具和几乎一致的技术信仰。

“有些人走着走着就散了。

十几年前,当中美两国的工程师们都在热烈讨论Hadoop、Spark和开源社区时,他们仿佛站在同一个新大陆的海岸线上,共享着同一套工具和几乎一致的技术信仰。

那是以技术为驱动、以效率为圭臬的黄金时代。彼时,中国的互联网巨头,如阿里巴巴和腾讯,是Hadoop和Spark生态的早期、大规模采用者,它们试图解决的是与硅谷同行们类似的、爆炸式增长带来的海量数据处理难题。

如今,图景已截然不同。

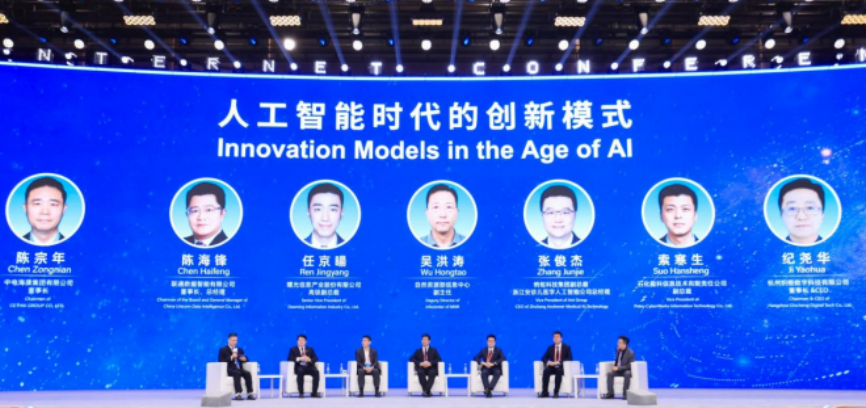

在2025年的硅谷峰会上,美国数据巨头Snowflake和Databricks的舞台中央,主角是AI智能体。他们向成千上万的开发者展示的是,不懂代码的业务人员如何用纯英语与海量数据对话,AI如何自动编写SQL,甚至自动将竞争对手的代码智能迁移过来。

而在同期的中国,大数据产业的核心落地场景,是服务于指挥中心和战略驾驶舱的数据大屏。

从赋权个体到赋权决策,从智能工具到治理系统。中美大数据产业不仅没有趋同,反而走向两个平行的未来。这种分歧并非偶然的技术路线差异,而是源自更根本的差异:两国对数据这一核心生产资料的定义不同——中国已在国家战略层面将数据定义为一种有待激活的新型生产要素;而美国和西方则在法规和文化的双重作用下,将数据视为一种需要管控的法律责任。

数据要素vs数据责任

中国的顶层设计中,数据被赋予了前所未有的战略高度。从十四五规划到2022年石破天惊的数据二十条,数据被明确定义为与土地、劳动力、资本、技术并列的第五大生产要素,成为基础性国家战略资源。

这是一套激活与流通的逻辑。当西方法规在研究如何规制数据时,中国的制度在探索如何激活数据,致力于激活数据要素潜能,做强做优做大数字经济。

最关键的机制创新在于“数据二十条”所提出的三权分置,该制度大胆地探索将数据产权进行结构性分置,划分为数据资源持有权、数据加工使用权、数据产品经营权。它深刻地揭示出,数据的非竞争性和产权模糊性使得传统的所有权概念在数据领域陷入僵局。西方在谁拥有数据的法律战陷入权利攻防之时,中国则通过三权分置绕开了这个问题。

正如“数据二十条”所强调的,要淡化所有权、强调使用权。通过将权利解绑,中国允许数据的价值在市场上合法流通和交易,而无需解决那个棘手的、近乎无解的原始数据归属问题。

与中国统一的、自上而下的数据要素战略不同,美国数据治理呈现出一种各自为政的图景,各州法律,譬如加州的CCPA、弗吉尼亚州的VCDPA等,和各行业法规,如医疗的HIPAA、金融的GLBA,共同组成监管体系。

与此同时,对美国数据文化影响最深远的,还有来自欧盟的《通用数据保护条例》。GDPR强大的域外效力,迫使所有希望与欧洲做生意的美国企业,必须将处理个人数据视为一种高风险的法律责任。

GDPR和CCPA共同在美国企业中催生了合规驱动的文化。数据不再首先被视为“机遇”,而是首先被视为一种法律和声誉上的风险。企业的首要目标不是最大化数据价值,而是最小化违规风险。这种防御性心态直接催生了合规科技和隐私技术栈。

可以说,中国的国家资本和政策导向正致力于建设数据流通的基础设施,而美国的市场资本和企业支出则正忙于构建数据防御的基础设施。

两种数据与产业的融合路径

对数据的微妙态度并非仅停留在抽象的政策文本中,而是直接决定了中美两国数据产业的微观技术路线和商业模式。

在美国,为解决数据治理和管理的难题,市场驱动和资本驱动的路径带来了技术化和产品化的空前繁荣。以Snowflake和Databricks为代表的现代数据栈是这一路径的巅峰之作。Snowflake的“三层解耦”架构和Databricks的Lakehouse(湖仓一体)架构都是为了解决分析这个核心问题。它们为企业IT和分析团队提供了前所未有的弹性、可扩展性和易用性。

然而,这种模式的B面,恰恰是其无法下沉到具体的、深入的产业运营场景中。这种过度依赖标准化产品的创新路径,使其在面对深度行业需求时显得力不从心。

以Snowflake为例,这类云数据仓库是卓越的分析引擎,但在应用后端的表现则差强人意。它们的设计目标是支持商业智能、分析和内部报告,而非面向用户的高并发、低延迟应用。具体行业将数据智能嵌入其核心交易或运营系统时,需要的是高并发和低延迟,而标准化数仓在这一场景下,要么成本高昂,要么用户体验缓慢。

更根本的问题在于,这种中心化数据平台模型在结构上就不适合支持真正的数字化转型。当来自制造业、医疗、运输等不同领域的数据被抽取、清洗并汇入一个中心化的、标准化的平台时,它们最有价值的领域特定上下文不可避免地被稀释和丢失了。

因此,美国的产品化路径,在追求横向扩展性的同时,牺牲了纵向穿透性。

中国的路径截然不同。如果说美国数据产业的超级客户是企业IT部门和资本市场,那么中国数据产业早期的超级客户只有政企和金融等机构。这种由大B和大G端需求和公共数据开放授权为牵引的模式,天然地塑造了数据产业的供给形态——项目制和定制化交付。

在西方的从业者视角看来,这种项目制模式是“落后”的,因为它缺乏可扩展性、利润率低、不是好的SaaS生意,但这是一种误读。

从中国数据要素战略的角度看,项目制不是需要被克服的弱点,而是实现其战略目标所必需的、被有意选择的优势。中国的战略目标不是打造一个可无限复用的单一数据产品,而是要打造一个数据要素与实体经济深度融合的产业生态。

实际操作层面看,项目制是实现“下沉”的重要手段,它能最大程度地深入产业的肌理。

譬如《“数据要素×”三年行动计划》,就提出在金融服务领域要融合“科技、环保、工商、税务、气象、消费、医疗、社保、农业农村、水电气”等多源数据,以“依法合规优化信贷业务管理和保险产品设计及承保理赔服务”。

这种跨越多主体、融合多维度、服务于特定场景的深度需求,必须通过项目制和定制化交付,在特定的场景中才能得以实现。

所以,美国模式的无法下沉是其标准化设计的必然结果,而中国的项目制则是数据要素与产业结合战略的必然选择。

AI时代的技术终局

在人工智能时代,中美走向了两个差异显著的发展路径,两种截然不同的数据智能。

美国路径的逻辑终点,是依循赋权个体、标准化产品、市场驱动的路径,通往AI智能体。以Snowflake和Databricks为代表的平台,其AI战略的核心是AI副驾驶。它们的目标是让分析师、营销人员、开发者等个体能够通过自然语言,自助式地完成过去需要一个数据团队才能完成的复杂工作。

这种自下而上的智能范式,追求的是个体生产力的最大化。它将数据智能封装在易用的工具中,分发给组织中的每一个人,以期带来效率的倍增,终极使命是优化组织中个体或团队的决策和生产力。

而中国路径则通往战略驾驶舱。一些观察者认为,中国大数据产业在AI时代卡在了可视化的低级阶段。事实上,中国的大数据产业,正在无限接近向数据智能的惊险一跃。

数据智能是一个更广泛的范畴,它涵盖了收集、整合、分析和展示数据的全过程,其目的是支持组织内的决策制定和战略规划。换言之,数据可视化只是数据智能的一部分,真正的智能隐藏在屏幕背后。

这类“屏幕后”的智能更接近AI时代的个性化管理,它由多源数据融合引擎支撑,执行着用数据要素结合实体经济复杂任务,其目标用户不是分析师,而是更高层级的管理者,其作用不单是提升个人效率,更是提供全局视野和宏观治理能力。

这是一种自上而下的智能范式,追求集体决策的最优化,将分散的数据要素汇聚起来,以实现战略层面的指挥和控制。

回望大数据这十年,中美两国从Hadoop和Spark的同一片海岸出发,如今已行驶在两条平行的轨道上,各自承载着不同的使命,驶向各自的星辰大海。

美国模式围绕产品、资本、责任,在数据责任的合规文化和活跃资本的推动下,形成了一套以标准化产品为核心的产业路径。其优势在于拥有全球最快的产品迭代能力和最活跃的开源生态;其困境在于高昂的合规成本,以及标准化产品无法下沉到深度产业运营中的结构性限制。

中国则在政务需求牵引下,聚焦数据要素的国家战略,形成一套以定制化项目为抓手的产业路径。其优势在于能以强大的国家意志完成庞大的数字基建,并通过项目制实现数据要素与实体经济的深度下沉融合,也面临着如何平衡项目制的定制化与平台化的规模效应等挑战。

在数字时代的浪潮中,两国基于自身截然不同的文化、经济结构和治理需求,做出了不同的战略选择,谁会率先走向真正的数据智能,还需要时间来验证。

来源:数据猿

我要评论

不容错过的资讯

大家都在搜