大数据技术简史:十年演化,万象归流

原创 月满西楼 | 2025-11-10 22:04

【数据猿导读】 如果你站在2010年,看着MapReduce把TB级别的日志压进Hadoop,然后花上几个小时跑出一个分析报告,你或许会觉得:这,就是“数据处理”的终极形态了。

“以史为镜,可以明得失。

如果你站在2010年,看着MapReduce把TB级别的日志压进Hadoop,然后花上几个小时跑出一个分析报告,你或许会觉得:这,就是“数据处理”的终极形态了。

如果你站在2015年,看着Spark用内存计算把作业时延从小时压到分钟级,你会惊叹:这才是真正的“快”。

如果你站在2020年,看着Kafka、Flink、ClickHouse拼凑出的数据平台“高并发实时反馈”,你会觉得:我们终于可以“接近实时业务”了。

但如果你站在2025年,回头看这些系统,你大概率会说:“太慢、太重、太碎。”

十年里,我们围绕“如何处理越来越多的数据”反复搭系统、弃系统、重构系统。

没有哪一个架构是真正“自上而下”设计出来的,它们几乎都是“前一代撑不住了”的结果。

·Hadoop架构被Spark打穿,是因为它太慢;

·Spark架构被Flink压制,是因为它不实时;

·Flink拼装出来的平台被Lakehouse取代,是因为它不好管;

·Lakehouse架不住多工具拼装的复杂性,最终被DataOS与智能体改写执行链路。

某种程度上,每一次“进化”,都是对上一代系统性的否定。

今天,我们讨论大数据技术栈的演进,不是为了追悼Spark或吹捧Flink,而是想看清一件事:当数据从TB级增长到ZB级,我们的架构如何从“管道系统”变成了“神经系统”?

这不是一条直线演进的故事,而是一次次结构性崩塌后的重构。

我们试图通过回顾过去的历史轨迹,来找到前路方向的一些蛛丝马迹。

因此,本文将拆解大数据技术,在过去十年中如何在碎片化、实时化、治理化、平台化、智能体化的夹缝中一路演进。

阶段一(2010–2013)

离线为王,数据“能算就行”

2010年前后,真正意义上的“大数据”概念开始走出实验室,进入企业级系统建设与商业部署。那是一个“数据量刚刚开始爆炸”的时代。对于企业来说,能将每天涌入的上百GB、上TB的日志数据处理完成,本身就是突破。

技术底座:Hadoop体系与MapReduce范式

当时最主流的技术框架是Apache Hadoop,它带来了两个革命性模块:

·HDFS(Hadoop Distributed File System):支撑TB级别以上数据的分布式存储;

·MapReduce:一种分而治之的计算模型,将大任务拆成Map(映射)与Reduce(归约)两个阶段并行处理。

它的优势很直接:可以用相对便宜的x86机器堆出一套“分布式计算集群”,极大降低了数据处理门槛。

在这之前,数据仓库是属于少数大企业、Oracle/IBM/SAP的贵族游戏。Hadoop让大数据第一次“平民化”。

工具演进:Hive、Pig等“类SQL”语言登场

之后出现的Hive:将SQL转译为MapReduce任务,成为Hadoop上的“数据仓库层”。另一方面,Pig则是一种更接近脚本语言的编排方式,适用于开发者写复杂逻辑。

这些工具的共同特征是:服务于批处理任务,作业粒度通常是小时级、天级,处理一次数据的成本高、周期长。

在那个阶段,“技术先进”不是主诉求,能把数据“吃进来、存下来、算完了”就算胜利。

架构强调稳定性大于灵活性,技术团队往往配备一批“数据工程师”专门负责MapReduce任务调度与失败恢复。

这个时候,在延迟、吞吐能力、应用场景等方面,特征也很明显:从数据进入到产生可视结果,普遍以“小时”或“天”为单位;能处理上百GB数据已属不易,PB级数据仍属极限操作;主要服务于广告点击日志、搜索关键词分析、电商用户画像等典型离线场景。

历史局限:批处理的边界被写死了

然而,正当越来越多企业部署Hadoop集群,享受“分布式计算带来的解放”时,问题也开始显现:

·数据时效性差:业务要求的数据反馈从“每日报表”变成“分钟级反馈”,Hadoop力不从心;

·编程门槛高:MapReduce基于Java编写,开发、调试成本极高;

·作业调度复杂:多个MapReduce任务之间的依赖管理极为困难,容错能力弱。

一句话总结这一阶段:“大数据终于能跑了,但还跑不快、也跑不稳。”

接下来的阶段,就是这一瓶颈的反噬——如何在不丢数据的前提下,把反馈时间压到分钟级甚至秒级?

这,正是Spark登场的时代。

阶段二(2014–2020)

从内存计算到实时流动,大数据计算系统的飞跃

这一阶段,是大数据技术真正“飞起来”的年代。Spark带来了“快算”的希望,Flink引领了“实时”趋势。六年间,大数据计算能力完成了从离线批处理,到实时反馈;从磁盘I/O,到内存调度;从单点工具,到平台组合的三重跃迁。

1.Spark崛起:大数据处理速度的指数跃迁

2014年,Apache Spark横空出世,标志着MapReduce模式的式微。作为内存计算引擎的代表,Spark用两大技术变革,开启了大数据计算的新时代:

·内存计算(In-Memory Computing):相比Hadoop动辄数小时的批处理,Spark将数据加载进内存,极大提升了处理速度,延迟从“小时”级压缩到“分钟”级甚至更低;

·DAG调度机制:以有向无环图的方式,动态调度任务执行路径,避免中间落盘,提升了容错与并行计算能力。

同时,Spark SQL的推出,也让大数据不再只是工程师的游戏。非技术人员可以用熟悉的SQL查询海量数据,推动了“数据民主化”的第一波浪潮。

2.Kafka+Flink:实时计算走向企业核心业务

在Spark让“快算”成为可能之后,企业对“实时反馈”的需求也水涨船高。2017年起,Apache Flink凭借其原生的流批一体架构,成为流处理的黄金标准。

·流批一体(Unified Streaming&Batch):Flink相比Spark Streaming更加原生地支持事件时间、窗口处理和状态管理,适配复杂的实时决策逻辑;

·Exactly Once语义:尤其在金融、风控等高一致性要求场景中,Flink的精确一次处理语义成为信任保障。

与此同时,Kafka 成为连接一切的数据动脉。Kafka+Flink+Presto逐渐替代了早期的Lambda架构,成为实时计算平台的新三件套。

但随着技术的发展,问题也逐渐浮现:Spark、Flink、Kafka、Presto、Airflow……各种工具的堆叠,让数据平台“能用”的同时,也变得越来越“难管”。平台间接口不统一,权限割裂、调度冲突、链路丢失等问题频发;数据血缘无法追溯,运维成本飙升,企业陷入“工具多、效率低”的窘境。

数据平台从“计算升级”阶段,进入了“架构瓶颈”阶段,企业开始意识到:速度不是终点,协同才是关键。

阶段三(2020–2023)

架构融合与治理重建,Lakehouse走向主流

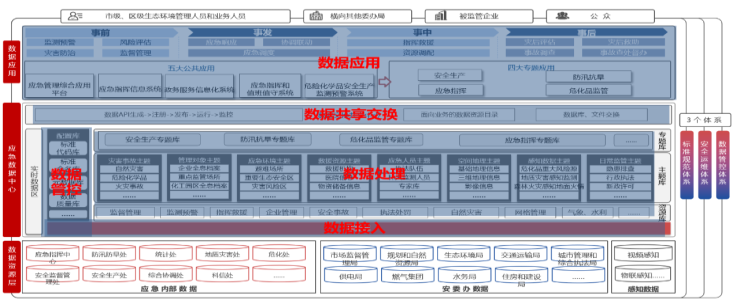

这一阶段,Lakehouse、Iceberg、Delta Lake、元数据治理、数据血缘、数据飞轮等,这些关键词逐步走入人们的视野。

1.Lakehouse:解决数据湖问题的“统一架构”

随着大数据技术的不断演进,数据湖的优势和问题愈发明显。它的核心优势是能存储海量的非结构化数据,但在数据治理、数据质量、数据检索效率等方面,存在显著的短板。

数据湖带来的一个重大问题是,虽然存储了所有数据,但大多数数据实际上无法被有效利用。数据进入湖中,但一旦没有清晰的标签、血缘关系和版本控制,就变成了“数据沼泽”。

Lakehouse应运而生,它结合了数据仓库的结构化管理优势与数据湖的存储优势,同时实现了ACID事务、版本控制和增量计算的支持,解决了数据湖的存取不便、治理困难等问题。

·Iceberg和Delta Lake:成为Lakehouse的关键技术,通过支持增量读取、ACID事务,统一了存储和计算的接口,让数据既能存储,又能高效计算。

·架构优势:支持大规模数据的实时查询、处理和管理,平台用户可以通过标准的SQL接口或ETL工具直接访问数据,无需担心数据质量问题。

Lakehouse的出现标志着数据架构的“统一”,让企业摆脱了数据湖”存得下但“用不来”的困境,也让数据治理不再是“理论上的愿景”而是“可以实施的实践”。

2.元数据管理与数据治理的重构:从“权限管控”到“数据可用性保障”

数据湖的最大挑战之一,除了存储问题外,还在于其缺乏有效的数据治理。企业存储了海量数据,但如果缺乏良好的元数据管理、数据血缘追踪、数据质量监控,这些数据就无法被有效利用。

这一阶段,随着数据湖向Lakehouse的过渡,企业对元数据管理和数据血缘追踪的需求变得更加迫切。

元数据不仅要管理数据的基本信息,还要能记录每一条数据的变化历史,并为后续的分析与决策提供足够的背景支持。

数据血缘则确保了每一条数据的来源与去向,让企业可以追溯数据的生成过程,判断其可靠性。

随着技术的成熟,DataOps(数据操作系统)理念逐渐兴起,企业不再仅仅依赖“数据管控”系统,而是基于数据质量管理、数据可用性保障和数据合规性监控的全方位治理体系,提供数据全生命周期的管理。

技术堆栈的升级,不仅解决了存储和计算的问题,还解决了数据流通性与质量控制,成为支撑企业数据驱动的坚实基石。

3.数据飞轮:从“工具拼装”到“系统协同”

这一阶段,“数据飞轮”的理念开始逐步占据主导地位,成为许多领先企业的数据战略框架。

数据飞轮的核心在于:“数据流动与使用将不断自我驱动,通过业务反馈不断产生新的数据驱动增长”。

具体而言,企业可以通过以下几种方式,来实现数据驱动增长的闭环:

·数据流转:通过智能调度系统和API接口,数据可以在不同平台之间流转,不再“关在某个系统里”。

·数据反馈:通过业务结果和性能反馈,进一步修正数据分析模型,让数据和业务的反馈机制形成正向循环。

·自动化决策:结合实时数据流与机器学习模型,系统可以自动判断和决策,减少人工干预,提高决策效率。

从数据中台到数据飞轮,企业不再单纯依靠“数据平台”,而是通过“数据流动、反馈、再循环”的方式,达到数据在生产、运营、决策等多个环节的全面利用。

这一阶段的技术核心是“数据协同”,不仅仅是一个平台的设计,而是一个跨工具、跨部门、跨生态的系统化协作。每一条数据都能“自动响应”,并与系统其他部分形成快速反馈链条。

阶段四(2023–2025)

智能体原生化,数据系统从展示工具转向决策系统

当然,历史的车轮不会停下前进的脚步。同样的,大数据的演进,还远未结束。事实上,就是近两年,大数据产业启动了一轮全新的“蜕变”,而这一轮变革的关键词是:Data Agent、DataOS、智能决策、自动化执行、闭环系统。

1.Data Agent:从数据处理到“数据行动”

2023年以后,尤其是进入2025年,随着人工智能技术的进步,Data Agent概念开始崭露头角。Data Agent并不只是一种数据分析工具,人们希望通过结合AI尤其是大模型技术,实现数据处理的自动化执行,并主动触发业务决策。人们对Data Agent的设想是:

·自动化执行:Data Agent能够基于业务需求、实时数据流、历史行为模式等,自动选择最合适的数据处理方法,触发分析并执行决策。

·智能触发:通过智能体与业务系统的深度融合,Data Agent能够根据数据流动的状态,自动反馈并执行任务,如调整价格、优化库存、调整广告投放等。

与传统的数据分析不同,Data Agent不仅能够解读数据,还能执行数据所触发的行动。它不再是一个单纯的工具,而是嵌入到业务决策流程中,成为企业自动化决策的一部分。

当然,截至目前,这些都还只是人们美好的愿望,或者说努力的方向。

2.DataOS:数据操作系统的崛起

随着企业数据管理的复杂性越来越高,传统的单一数据平台已经无法满足需求。于是,DataOS(数据操作系统)的概念应运而生,它作为大数据技术的下一个演进方向,正在成为未来企业数据架构的核心。

·操作系统的理念:像传统操作系统(OS)管理硬件资源一样,DataOS将负责调度数据、管理计算资源、执行决策任务、保障系统稳定等功能。

·资源调度:DataOS不仅仅管理存储、计算等底层资源,还通过智能调度引擎确保不同数据平台和工具的协同工作。

DataOS的本质是将数据处理、数据存储、计算资源、调度机制、智能决策、执行层等有机结合,形成一个“数据驱动”的整体生态。企业的每一项决策将不再是“人工决定+数据辅助”,而是“智能系统自动触发并执行决策”。

3.智能化闭环:从“数据看板”到“自动决策”

随着Data Agent和DataOS的普及,数据系统逐渐从“报表系统”转向“自动决策系统”。数据不再仅仅停留在展示层,而是能够在实时处理后直接触发业务决策,形成智能化闭环。数据闭环的三大要素:

1.数据采集与存储:从多个来源实时接入并存储不同类型的数据(结构化、半结构化、非结构化)。

2.实时处理与分析:通过智能算法对数据进行即时分析、处理,并提取洞察。

3.自动决策与反馈:基于分析结果,Data Agent主动触发行动,如自动调整营销策略、优化库存、或改变供应链调度等,最终形成“数据→洞察→决策→行动 →反馈”的闭环。

当然,目标越高,往往难度越大。我们的长征,才刚刚开始。

人类第一次

可以在毫秒级尺度上认识世界

2008年,MapReduce写下第一行大数据计算的代码。

2014年,Spark把数据从磁盘提进内存。

2017年,Flink让数据流动起来,不再等待下一批任务。

2020年之后,数据处理速度的单位,变成了“毫秒”。

在这个尺度下,人类第一次,拥有了“即时理解世界”的能力。广告点击、电商推荐、金融交易、工业预警……每一秒钟,都有无数个系统在“观察、判断、反应”。机器开始参与世界的运行逻辑。

但与此同时,我们也第一次,无法完整地理解我们所构建的系统。

数据处理从未如此快,也从未如此复杂。每一次技术的跃进,背后是更多的抽象层、更多的组件耦合、更多对协同能力的依赖——而这些,是技术之外的挑战。

这是大数据的悖论:我们构建了前所未有的感知系统,却仍在摸索如何让它真正服务于人。

未来不会变慢。但我们必须学会,如何在更快的系统里,做出更稳的决策。

来源:数据猿

刷新相关文章

我要评论

不容错过的资讯

大家都在搜