AI不决定命运,但照亮方向

原创 一蓑烟雨 | 2025-07-03 18:23

【数据猿导读】 一场关乎命运的决策,正在由AI参与。人们开始思考:“AI,真的能帮我做出人生最重要的决定吗?”

高考结束了,最让学子们揪心的莫过于志愿填报了。

现在,志愿填报有一些新“玩法”。让我们来看一个例子。

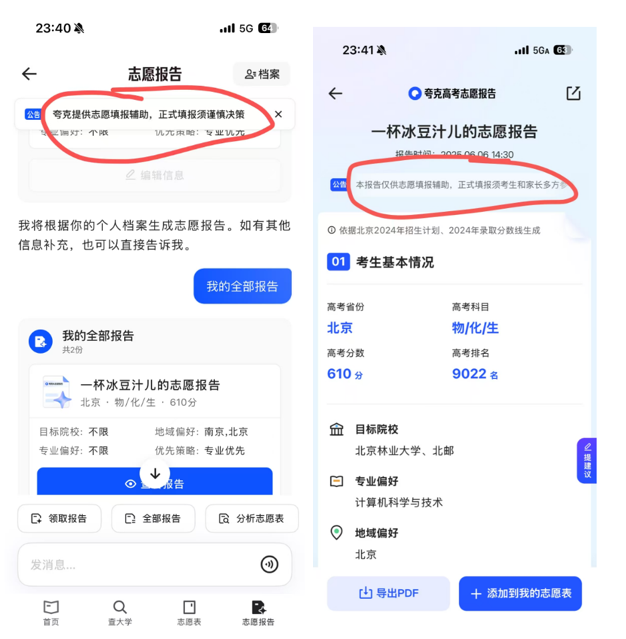

她叫王琳(化名),来自贵州一座普通县城的重点中学。高考结束那晚,她拿着刚出分的成绩单,站在父亲借来的一部旧安卓手机前,在夸克App里输入了一句话:

“我想学经济,但不想离家太远。”

十秒钟后,一份清晰、结构完整的志愿报告出现在屏幕上:它不仅列出了她最可能被录取的高校,还标注了每一所学校的优势专业、城市发展、就业方向,甚至分析了“经济类对女生未来职业选择的弹性较高”——这是她此前从未听说过的信息。

在一个月内,王琳修改了近60次报考偏好,最终锁定了西南财经大学。

她不是个例。2025年高考季,夸克官方数据显示,其“志愿报告Agent”累计为考生和家长生成超1000万份志愿报告,成为中国AI技术在垂直领域最大规模的深度研究型应用。

一场关乎命运的决策,正在由AI参与。人们开始思考:“AI,真的能帮我做出人生最重要的决定吗?”

AI志愿Agent到底做了什么?

志愿填报是一项高度复杂的任务。它不是简单地“根据分数筛学校”,而是要在考生的个人偏好、成绩、家庭背景、城市意向、专业兴趣、未来发展、就业趋势之间,找到一条可行又理想的路径。

在此之前,很多家庭只能依赖“亲戚推荐”“老师意见”甚至“网上搜索来的碎片信息”来做决策。

而夸克推出的“志愿报告Agent”,正是要用AI,帮用户拆解需求、规划路径、执行决策、反思调整,走完整套流程。

这背后的技术关键是:“任务规划—执行—检查—反思”四阶段Agent机制。

与传统的问答系统不同,志愿Agent更像是一个“沉浸式助手”:

一是任务规划,理解你想要什么。

例如考生输入:“我倾向于广州深圳,不考虑偏远地区,想学人工智能,数学不太好”。

AI会自动识别出:地域偏好+专业目标+能力约束等多维度信息,并将其拆解为后续决策的执行路径。

二是任务执行,调用各种工具操作志愿表。

执行过程不仅调用搜索与知识库,还结合夸克自建的志愿填报工具(涵盖3000多所高校、2000多个专业的历年数据),生成初步填报方案。

三是结果检查,看是否满足你的意图。

比如,如果在广州深圳地区无法满足“人工智能”且匹配度高的选项,系统会返回反馈并触发反思机制。

四是自我反思,重新调整路径再尝试。

AI会尝试扩展方案,例如“是否考虑广东省内其他城市?”或者“是否放宽对高校层次的限制以争取更多选择?”

整个过程是一个类专家的策略性探索,而不是一锤子买卖。

这种能力并非依赖一个模型,而是一个系统性的集成:由高考志愿大模型+知识库+搜索+决策工具+反馈机制构成的智能体(Agent),实现了从用户语言→智能规划→动态反馈→报告输出的完整链路。

换句话说,它不是“在回答问题”,而是在“模拟决策过程”。

夸克凭什么?拆解夸克的核心技术

“AI Agent”不是一个新概念,但真正做到实用、稳定、规模化落地的案例寥寥无几。我们可以把它看作一场“大模型+工具链+垂直知识”的协同作战,夸克的志愿报告Agent之所以备受关注,不只是因为它生成了一千万份报告,更因为它在数据、模型、工具三大技术支柱上,构建出了严谨而高效的闭环系统。

第一支柱:高质量、结构化、权威的数据底座

填志愿是“信息决策”的典型场景,但高考相关的信息极度碎片化,且权威性参差不齐。

为确保数据可用性与准确性,夸克对外部信息源做了大规模清洗与重构:收录8000+高考相关站点、几十亿级网页内容,覆盖99%以上权威源;引入非网页数据,如各省考试院、招生简章等;针对近三年招生计划、录取分数、体检要求、就业考研数据等,夸克动用数百人工审核,构建起近似“高考百科全书”的数据库。

特别是志愿工具所依赖的数据集,涵盖了全国3000多所高校,2000多个专业,包括不同省份、选科模式等复杂变量。

这使得生成的每一份志愿报告,具备了“与现实高一致性”的基础。

第二支柱:高考专属大模型+强化学习优化

在大模型方面,夸克基于通义千问的基座模型,做了大规模后训练,包括:高考垂直领域微调训练;引入权威知识库作为RAG材料源;应用RLHF(人类偏好强化学习)+RLVR(可验证奖励强化学习)机制,提升推荐结果的可靠性与用户接受度。

特别是在“志愿推荐”中出现的典型矛盾——例如“分数刚好能上,但专业可能不喜欢”——模型通过RLHF打分来捕捉用户偏好,又用RLVR确保事实不偏离,两种奖励机制协同调和“真实可行”与“用户满意”之间的张力。

此外,在数据结构和策略表达上,模型能将自然语言转化为专家级指令,执行对志愿表的精细操作:

按地域优先级(如“广州 > 广东省内 > 非偏远地区”)调整选项;

匹配专业要求与考生学科能力(如“数学弱不建议报人工智能”);

在资源不足时触发“策略放宽”或“冲刺建议”。

从语言理解到意图规划、再到表格操作与策略反馈,这种复杂流程的闭环,标志着真正具备实战能力的AI Agent系统。

第三支柱:多轮执行与人机协同的志愿工具

模型不是孤岛。它与志愿工具之间的交互,决定了生成结果的可执行性与可信度。

每一次模型生成的指令,都会传送给志愿表工具进行实时模拟与反馈。

如果反馈结果不理想,模型会“反思”:是否扩大地理范围?是否降低院校层级?是否调整专业优先级?并重新生成推荐方案。

这不仅是“模型生成一个表”,而是:模型推理+工具执行+数据反馈+策略反思的动态任务系统。这是AI真正从“内容生成”,进化为“决策协助”的关键一步。

在产品方面夸克又做了什么,

来优化用户体验?

高考填报,不只是信息问题,更是认知问题——很多考生和家长,不知道该问什么、更不知道该怎么选。而夸克在产品层的最大突破,是把“复杂的AI能力”转化成了“用户可理解、可操作、可信赖的交互体验”。

这背后的核心,是三个产品层级的融合:

第一层:AI问答,扫除信息盲区

夸克在搜索系统基础上,搭建了专属的高考问答模型体系,可以系统性地回答所有高考相关问题——

什么是强基计划?

某某专业适合女生吗?

某高校去年在江苏的最低位次是多少?

不同于传统搜索给出一堆链接,夸克的AI问答直接给出结构化、精炼答案,并附带数据来源与解释说明。对很多第一次接触志愿填报的家庭来说,这个阶段就极大降低了“信息焦虑”。

第二层:志愿工具,帮助用户自助筛选

如果说问答是信息入口,那“志愿工具”就是用户自定义筛选的空间。它支持用户:输入分数、位次、选科、地区、意向专业;进行分段筛选(冲、稳、保);查看历史录取分数、波动预测、招生计划等关键数据。

这个功能面向熟练用户或愿意亲手操作的人群,提供了极高的自由度,但并不强依赖AI生成。

第三层:志愿报告Agent,一站式“决策路径规划器”

而真正将AI的“专家决策力”推向C端用户的,就是今年重点上线的志愿报告Agent功能:

用户只需用自然语言描述意图(如“我不喜欢数学,但想学计算机,想在山东省内上公办院校”);

Agent将自动规划填报策略→调用工具→调整筛选逻辑→生成结构化志愿报告;

每所推荐学校附带解释逻辑、风险等级、专业匹配度、地域分布等信息;

最终输出一份可下载、可打印、可分享的完整志愿报告,并支持后续反复修改。

这是因为在技术和产品层面的深耕,夸克在这场高考志愿填报的“考试”中,也取得了不错的成绩:

生成报告总量超1000万份,为国内最大规模的AI辅助决策应用之一;

用户主动分享率超40%,说明报告不仅被看,还被信赖、传播;

超过50%的用户来自三线及以下城市,显示出AI产品在信息弱势群体中的巨大价值;

个别用户最多生成多份志愿报告,表明Agent系统具备持续交互与反馈能力,支持“逐步决策”而非一次定论。

此外,夸克在部分乡村中学开展的线下调研也显示,许多考生“甚至不知道自己应该问什么问题”,只能机械地说“我成绩不差,想考师范”。在这种场景下,AI系统不只是一个工具,更是一位能够引导、澄清、建议的决策合伙人。

夸克产品负责人蒋冠军曾表示:“在很多领域,用户的需求已经复杂到无法用常规搜索满足,我们希望AI真正成为身边的专家型助手。”

高考志愿填报,

只是人生决策的“冰山一角”

在AI应用层的众多落地尝试中,“教育”始终是最被寄予厚望的场景之一。但现实中,很多产品停留在表层应用:题目讲解、作文批改、知识问答……真正涉及高认知决策、复杂多目标推理、数据深度整合的产品极少。

夸克高考志愿Agent的出现,意味着AI在教育领域第一次实现了结构性能力突破。

1. 从“聊天式AI”到“任务型AI”的转变

传统AI教育产品多为ChatBot式单轮问答,例如“我这个分能不能上某高校”“XX专业前景如何”。但真正的志愿填报决策包含:

认知澄清(你真的知道你想报的专业是干什么的吗?);

意图平衡(父母希望稳定vs孩子想挑战);

数据对齐(分数、位次、地域、学校批次、专业类别);

策略执行(冲/稳/保布局、录取概率计算、限制条件控制)。

这不是“问一个问题、得一个答案”,而是“发起一个任务、走完一套流程”。Agent机制正好适配了这一认知模型。

2. 技术深度已超越行业平均水位

据夸克算法负责人唐亮介绍,志愿Agent所依赖的大模型,经过了高考专属微调、任务规划训练、强化学习打分等多轮迭代。模型不仅能理解考生意图,还能生成可执行指令、控制外部工具调用、动态调整策略。

相比多数“生成类AI”停留在内容层,夸克已经实现了“推理—行动—反思—重构”的链式闭环。

此外,其幻觉控制能力也得到显著提升,幻觉率得到大幅优化,确保用户不会因为“编造内容”做出错误决策。

3. 数据结构化、语义映射能力构筑护城河

很多厂商尝试进入高考志愿领域,但长期无法突破的点在于:

数据颗粒度过细,来源不统一:不同学校、不同地区、不同政策下的招生计划和分数线标准不一;

专业信息需结构化理解:比如“人工智能”是否对数学有要求、“金融学”是否更适合理科生;

用户语言模糊,意图不稳定:如“想留在南方、不去太冷的城市”,需要进行语义拆解与标准化建模。

夸克通过7年积累构建出的数据库+工具链+高考知识图谱,使其具备了超出“产品设计”层面的语义基础设施能力。而这正是其他竞品难以快速复制的核心壁垒。

4. 决策类AI产品的新范式:可迁移、可拓展

更重要的是,高考志愿Agent所采用的整体框架,具备强可复制性。

任何“多目标、有限信息、路径分歧”的复杂决策问题,都可视为Agent应用场景:考研/升学规划、留学择校、就业方向决策、医疗就诊路径推荐、财务投资组合规划。

这正是“深度研究技术”的宏观目标——不只是服务一个场景,而是打造AI助手完成复杂任务的能力模型。

从“会答题”到“会做决策”,这是AI与人类认知模型之间距离的真正缩小。

当AI成为“建议者”,谁负责“决策”?

夸克的志愿报告Agent在提供决策支持上无疑取得了巨大的技术突破,但在用户层面,一个新的问题悄然浮现:“我到底能信AI到什么程度?”

这一问题的本质,并不在于模型准不准,而在于建议权与决策权的边界是否清晰。

1. 用户高度信任背后的风险

从用户行为来看,AI生成的志愿报告正被越来越多的家庭视作“决策依据”:报告支持六维度打分与排序(地域、专业、学校层级等),最终输出“推荐表单”;推荐内容标注有“冲、稳、保”分级;用户可直接使用该表进行志愿填报操作,流程顺滑。

但问题在于:很多用户,尤其是中小城市和乡村的考生与家长,未必具备评估“AI推荐合理性”的能力。他们对算法的信任,很容易转化为过度依赖。

“AI给我这个学校,那应该没问题吧?”

“专业看起来是推荐的第一位,我就选它吧。”

这种“把选择责任转嫁给AI”的心理,很容易在事后引发落差感、甚至信任危机。

2. 建议vs命令:AI的解释能力需要加强

AI生成的志愿报告虽然已经附带一定的解释,如“因你的地域偏好和分数匹配推荐XXX专业”,但目前尚未全面实现:专业推荐逻辑的充分透明化;用户可调节的偏好权重;对冷门、边缘选项的完整披露。

例如,如果模型判断用户可被A专业录取,但该专业冷门、城市偏远、信息量稀缺——在报告中,这种“反例”往往被自然过滤。用户失去了做“不选”的机会。

在志愿填报这种强关联未来路径的场景中,让用户知道“为什么推荐”,甚至“为什么不推荐”,与“推荐了什么”同样重要。

3. RLHF与RLVR的博弈:个性偏好vs客观事实

夸克团队在模型训练中采用了RLHF(人类偏好)+RLVR(可验证事实)双重强化机制:RLHF捕捉用户在报告排序、内容表达、推荐偏好等方面的感受;RLVR确保输出内容在逻辑和事实层面不能出错。

但在现实应用中,二者会出现“错位”:一个冷门专业(如地质工程)可能事实匹配度高、录取概率大,但用户天然抗拒;一个热门专业(如金融、人工智能)可能录取概率低,但用户强烈倾向。

面对这种“理性结果vs情绪偏好”的冲突,模型必须在建议维度做出选择。如何解释这种选择,并允许用户干预调整,是下一步产品必须解决的问题。

4. 责任的边界,需要更明确的制度设计

目前,夸克的产品设计中,强调AI报告的辅助性质。

但从实际操作层面来看,随着AI能力的提升,可能会导致人越来越依赖AI给出的建议的问题。一旦出现决策失误,人们往往倾向于归罪于AI系统。这有点类似于目前的汽车自动驾驶领域,虽然车企反复强调自己提供的只是辅助驾驶系统,但是越来越多的用户慢慢养成了依赖自动驾驶的习惯,一旦出现严重车祸,车企依然可能陷入被动的局面。

因此,为了捋清责任关系,需要更明确的制度设计,来确定责任边界。从长远看,任何AI决策产品都必须解决“建议权”与“决策权”的明晰分离:建议应是解释型的、可复现的、可调节的;决策必须由用户明确下达指令,并了解其依据与后果;系统应提供“反思空间”与“用户选择确认”机制,避免误信或误解。

需要让人们清楚的意识到,AI是助力,不是替代。尤其在关乎命运的选择上,责任必须由人类自己承担。

需要指出的是,高考是一场信息战,也是一场认知战。它要求每个考生和家庭在短时间内,做出一次关于未来的复杂选择。但对于绝大多数人来说,这场战役的起点并不公平:

有人有家教、咨询师、老师资源;

有人只能靠零散搜索、亲戚建议;

更有人根本不知道,哪些信息该去问、该怎么问。

AI志愿Agent的价值,恰恰不在于替你决定,而在于让你拥有“做出好决定”的条件。

夸克的这一产品,不是单纯的“模型秀肌肉”,而是一次工程能力、数据整合、产品理解与社会价值的协同实践。它让AI不再只是技术热词,而是落到千千万万个考生和家长手中,一次次输入模糊指令、反复修改偏好、慢慢明白自己到底想要什么。

你或许不会完全照着AI生成的那份报告填志愿,但它提供的,是一个路径,是一张地图,是一盏在混沌中亮起来的灯。

未来,这种“深度研究式AI助手”还将进入更多决策领域:从考研、留学、择业到医疗、养老、投资规划。它将不再是“懂你说什么”的AI,而是“能陪你想清楚”的AI。

但最终,AI不是命运的仲裁者。

人生方向,还是需要人自己走。

来源:数据猿

我要评论

不容错过的资讯

大家都在搜