阿里Qwen3大模型登顶开源冠军,中国AI应用即将迎来大爆发?

原创 梦芸 | 2025-05-01 13:59

【数据猿导读】 4月29日,阿里巴巴正式发布新一代通义千问模型——Qwen3(以下称“千问3”),这一发布在全球科技圈引发震动。

人工智能领域又一重大突破!

4月29日,阿里巴巴正式发布新一代通义千问模型——Qwen3(以下称“千问3”),这一发布在全球科技圈引发震动。

千问3的最大亮点在于其卓越的效率与显著降低的成本。据悉,千问3的模型大小仅为相近性能模型的三分之一,但其性能却全面超越了包括R1和OpenAI-o1在内的全球顶尖模型,登顶全球最强开源模型。

值得强调的是,千问3是国内首个“混合推理模型”,将“快思考”与“慢思考”有效整合于同一模型中。通俗来说,对于简单问题,千问3能够以低算力实现“秒回”;而面对复杂问题,则能通过多步骤的深度思考,显著节省算力消耗。这一设计实现了推理机制与最低成本之间的最佳平衡。

据悉,千问3开源后,上下游供应链连夜进行适配和调用,NVIDIA、联发科、AMD等多家头部芯片厂商已成功适配千问3。在阿里通义千问模型千问3模型开源数小时后,华为官方宣布昇腾支持千问3全系列模型部署,开发者在MindSpeed和MindIE中开箱即用,实现千问3的0Day适配。

对此,数据猿第一时间对千问3在数学、代码生成、文字创意上进行了几道简单的实测,先是输入了一道2024年高考数学题。

在页面提问后,页面会显示此次思考所用的“思考预算”,用户可以根据实际需求,调整深度思考所需的tokens数量,从1024tokens到38912tokens,从而实现不同程度的思考。

已知三角形ABC的内角A、B、C的对边分别为a、b、c,若a=3,b=4,C=60°,求三角形ABC的面积。在这道高考数学题中,笔者分别用no think和think模式,其都回答正确。

其次,又在指令栏里输入:创建一个红白机风格的"贪吃蛇"游戏,包含自动演示AI功能,使用纯HTML/CSS/JavaScript实现为单文件

生成游戏代码

性能登顶

千问3的“混合推理”

据介绍,此次发布的千问3在推理能力、指令遵循、工具调用及多语言能力等方面均有显著提升,创造了国产模型及全球开源模型的新性能高峰。

千问3拥有五大关键特性:一是独特的混合推理能力,能够在思考模式和非思考模式之间灵活切换,以适应不同场景的需求;二是在数学、代码生成和常识逻辑推理等方面的推理能力得到了显著增强;三是表现出卓越的人类偏好对齐,在创意写作、角色扮演、多轮对话和指令跟随等场景中提供出色的对话体验;四是智能体能力突出,能够在两种模式下精准集成外部工具,在处理复杂的基于代理的任务时展现出强大的竞争力;五是具备强大的多语言能力,支持119种语言和方言,极大地拓展了其应用范围。

其中,千问3在代表奥数水平的AIME25测评中,获得了81.5分,刷新了开源纪录;在考察代码能力的LiveCodeBench评测中,突破了70分大关,表现甚至超过了Grok3;在评估模型与人类偏好对齐的ArenaHard测评中,千问3以95.6分超越了OpenAI-o1及DeepSeek-R1。

好奇千问3为何能表现出如此强劲的实力?实际上,高性能、低成本的秘密,其实藏在千问3独特的“混合推理”模式中。

如何理解“混合推理”?

通俗来说,相当于把顶尖的推理模型和非推理模型集成到同一个模型里去,遇到简单问题模型能瞬间给出答案,算力消耗很少,但遇到复杂问题,就开启复杂思考模式。技术门槛很高,通常需要经过精心设计的多轮强化学习训练,才能实现模型智能最终的巨大飞跃。目前,热门模型中只有千问3、Claude3.7以及Gemini 2.5 Flash可以做到。

以DeepSeek类比,V3是Chat/Instruct 模型,R1 是 Reasoning 模型,在使用时,需要打开/关闭深度思考;但在部署时,需要分别部署两套模型,这样就占用了极大的算力资源。而 Qwen3 全系列都有推理能力,且小模型也能做推理。

具体而言,在“推理模式”下,模型会执行更多中间步骤,如分解问题、逐步推导、验证答案等,给出更深思熟虑的答案;而在“非推理模式”下,模型会快速遵循指令生成答案。同一个模型,可以完成“快思考”和“慢思考”,这类似于人类在回答简单问题时,凭经验或直觉快速作答,面对复杂难题时再深思熟虑,仔细思考给出答案。

千问3还可API设置“思考预算”(即预期最大thinking tokens数量),进行不同程度的思考,让模型在性能和成本间取得更好的平衡,以满足开发者和机构的多样需求。

正是因为它的“超高性价比”,能在提升模型本身智能水平的同时,整体降低算力资源消耗。如今混合推理的大模型路线,正成为顶级大模型公司争相突破的前沿技术领域。有研究显示,综合来看,推理模式下的成本可能是非推理模式的数倍(2到5倍)。

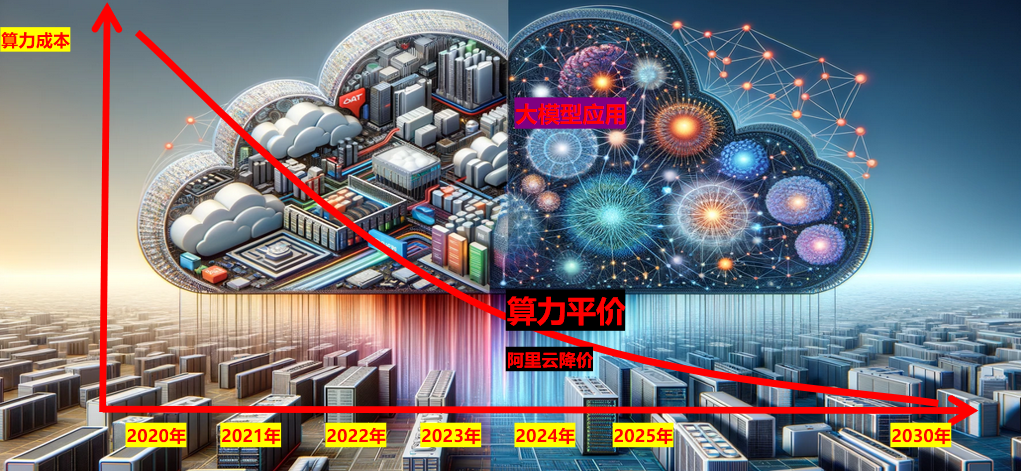

成本“断崖式”下降

中国AI应用即将迎来大爆发?

除了上文说的性能提升,此次千问3开源还显著降低了部署成本。现在,仅4张H20显卡即可轻松部署千问3旗舰版,可以说是把大模型的部署门槛压到了地板。

可别小看这点。实际上,自打大模型出来后,大家考虑的是如何将这些模型更好的融合到业务中。

为了满足不同场景的应用需求,据介绍,此次千问3共开源了8款模型,其中,包含2款MoE模型(30B和235B),以及6款参数规模各异的稠密模型(参数量分别为0.6B、1.7B、4B、8B、14B、32B)。

其中,千问3的30B参数MoE模型实现了10倍以上的性能杠杆提升,仅需激活3B参数,就能媲美上一代Qwen2.5-32B模型的性能。而千问3的密集模型性能也在持续突破,以一半的参数量实现了同等高性能。例如,32B版本的千问3模型,其性能甚至能够跨级超越Qwen2.5-72B模型。

每款模型均代表了同尺寸下的开源最佳性能,这些模型针对不同的应用场景进行了优化。

例如,小参数模型适用于实验和科研,4B模型适合手机端,8B模型适合电脑或汽车端,14B模型便于普通开发者进行落地应用,而32B模型则是企业和大规模部署的首选。两款MoE模型中,旗舰版的235B-A22B模型凭借其高效性能,适用于企业本地部署和云部署;较小的30B-A3B模型则以快速响应和良好效果,适合对速度有较高要求的应用场景。

推理大模型的能力增强,将适用场景进一步拓展。但其中有一个问题是,推理大模型极其依靠算力的投入,背后就是大量的算力成本投入。这成为了阻碍企业适用大模型普及的因素。

从这点看,此次千问3的开源,显得极具价值。未来或许会让更多的人、企业都可以享用到用得起、用得好的尖端AI技术。特别是它的各种小尺寸模型,对后续手机、智能眼镜、智能驾驶、人形机器人等智能设备和场景的部署更为友好。再加上,所有企业都可免费下载和商用千问3系列模型这点,或将大大加速AI大模型在终端上的应用落地。

从模型推理上看,千问3独特的混合推理模型,开发者可自行设置“思考预算”,在满足性能需求的同时实现更精细化的思考控制,自然也会节省整体推理成本。可以参考的是,同类型的Gemini-2.5-Flash在定价上的推理和非推理模式的价格相差约6倍,用户使用非推理模式时相当于可节省600%的算力成本。

千问3性能图

值得一提的是,在阿里通义千问模型千问3模型开源数小时后,华为官方宣布昇腾支持千问3全系列模型部署,开发者在MindSpeed和MindIE中开箱即用,实现千问3的0Day适配。

此前华为昇腾就一直同步支持千问系列模型。昇腾MindSpeed训练、MindIE推理支持千问2.5、兼容主流生态的分布式并行接口等,千问3系列模型一发布即实现低代码无缝迁移。

千问3开源后,上下游供应链连夜进行适配和调用,NVIDIA、联发科、AMD等多家头部芯片厂商已成功适配千问3。联想旗下的智能体应用“百应”也同步接入千问3,在语言理解、多轮推理、指令跟随等关键能力上实现了跃升。

坚持开源:首次支持119种语言

为全球开发者铺平道路

千问3为即将到来的智能体Agent和大模型应用爆发提供了更好的支持。

在评估模型Agent能力的BFCL评测中,千问3创下70.8的新高,超越Gemini2.5-Pro、OpenAI-o1等顶尖模型,将大幅降低Agent调用工具的门槛。

同时,千问3原生支持MCP协议,并具备强大的工具调用(function calling)能力,结合封装了工具调用模板和工具调用解析器的Qwen-Agent 框架,将大大降低编码复杂性,实现高效的手机及电脑Agent操作等任务。

据了解,千问3系列模型依旧采用宽松的Apache2.0协议开源,并首次支持119多种语言,全球开发者、研究机构和企业均可免费在魔搭社区、HuggingFace等平台下载模型并商用,也可以通过阿里云百炼调用千问3的API服务。个人用户可立即通过通义APP直接体验千问3,夸克也将接入千问3。

通过结合Qwen-Agent开源框架,开发者可以充分发挥千问3的智能体能力。Qwen-Agent是一个基于Qwen的指令跟踪、工具使用、规划和内存功能开发大型语言模型(LLM)应用程序的框架。该框架内部封装了工具调用模板和解析器,并附带浏览器助手、代码解释器和自定义助手等示例应用,大大降低了编码复杂性。

开发者可以基于MCP配置文件定义可用工具,利用Qwen-Agent的集成功能或自行集成其他工具,快速开发具有设定、知识库RAG和工具使用能力的智能体。

Qwen3开源模型家族

通义千问一直致力于开源事业,并将语言支持从29种扩展到119种,意味着更多国家和地区的人们能够使用自己的语言享受AI技术带来的便利。

具体来看,此次千问3支持119中语言,不但囊括了中、英、法、西、俄、阿拉伯等主要的联合国语言,还包含了德、意、日、韩、泰、越南、尼泊尔、瑞典、波兰、匈牙利等各国官方语言,以及中国的粤语、非洲的斯瓦西里语、中东的意第绪语、西亚的亚美尼亚语、东南亚的爪哇语、美洲的海地语等地方性语言。许多国家和地区没有技术能力开发自己语种的AI大模型,随着千问3的开源,全球各国各地区的人从此有了自己的AI大模型。

据悉,从2023年至今,阿里通义团队已开源200多款模型,包含大语言模型千问Qwen及视觉生成模型万相Wan等两大基模系列,开源囊括文本生成模型、视觉理解/生成模型、语音理解/生成模型、文生图及视频模型等「全模态」,覆盖0.5B、0.6、1.5B、3B、4B、7B、14B、30B、32B、72B、110B、235B等「全尺寸」参数,屡次斩获Chatbot Arena、司南OpenCompass等权威榜单“全球开源冠军”、“国产模型冠军”,多次登顶HuggingFace、Github的最热趋势榜单。

目前,通义千问Qwen衍生模型数量已突破10万,超越美国Llama模型,通义成为全球第一AI开源模型。通义千问Qwen在全球下载量超过3亿,在HuggingFace社区2024年全球模型下载量中千问Qwen占比超30%,稳居第一。在2025年2月的Huggingface全球开源大模型榜单(Open LLM Leaderboard)中,排名前十的开源模型全部都是基于千问Qwen二次开发的衍生模型。

在李飞飞领衔的斯坦福HAI研究所发布的《2025年人工智能指数报告》显示,2024年重要大模型(Notable Models)中,阿里入选6个,按照模型贡献度排名,阿里AI贡献位列全球第三。

来源:数据猿

刷新相关文章

我要评论

不容错过的资讯

大家都在搜