火山引擎发布豆包系列模型升级,披露日均tokens超30万亿

数据猿 | 2025-10-16 13:22

【数据猿导读】 10月16日,在 FORCE LINK AI 创新巡展武汉站上,火山引擎发布了豆包大模型的系列更新,包括豆包大模型 1.6 原生支持多种思考长度,并推出了豆包大模型1.6 lite、豆包语音合成模型2.0、豆包声音复刻模型2.0等全新模型。

10月16日,在 FORCE LINK AI 创新巡展武汉站上,火山引擎发布了豆包大模型的系列更新,包括豆包大模型 1.6 原生支持多种思考长度,并推出了豆包大模型1.6 lite、豆包语音合成模型2.0、豆包声音复刻模型2.0等全新模型。

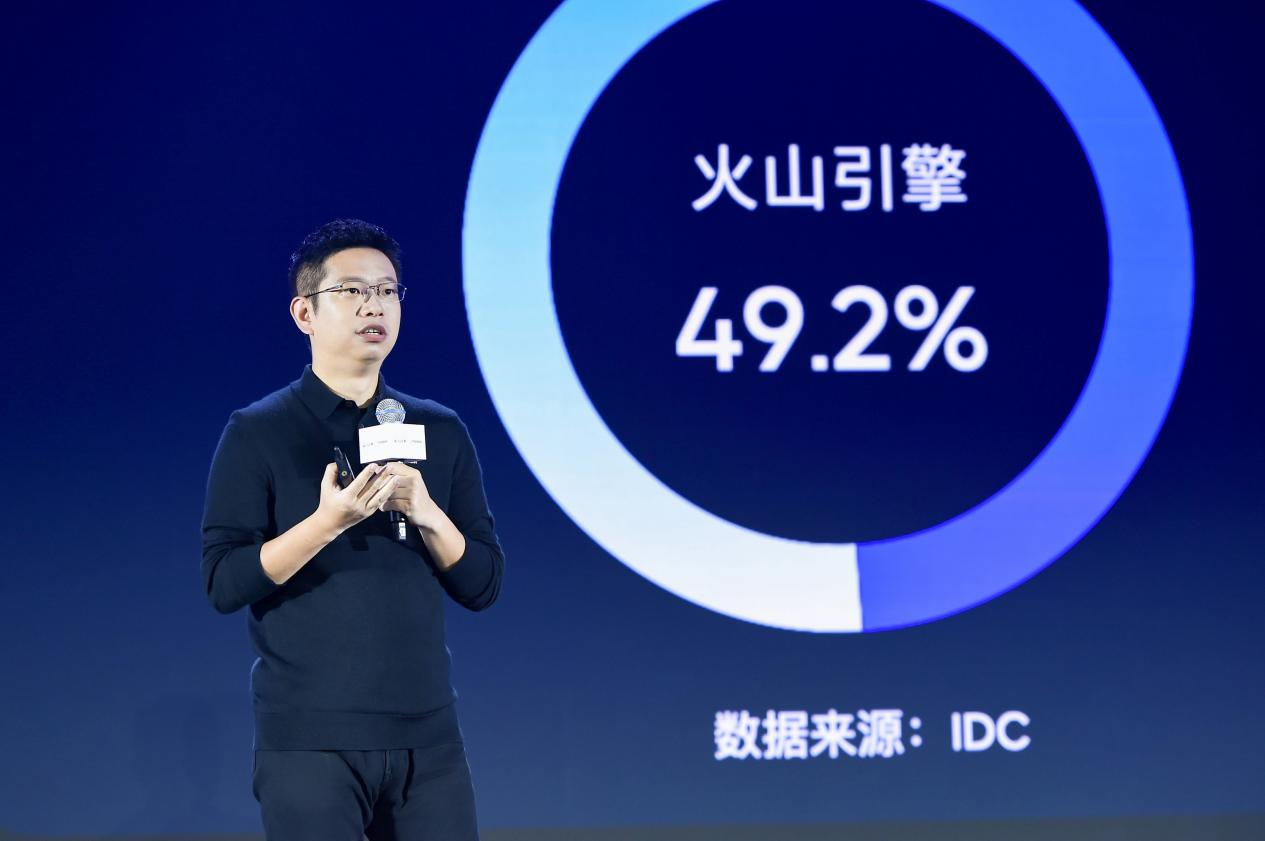

随着AI产业落地持续加速,截至2025年9月底,豆包大模型日均tokens调用量已突破30万亿,相比今年5月底增长超80%。在企业市场,IDC报告显示,2025年上半年中国公有云大模型服务市场,火山引擎以49.2%的份额占比位居中国第一。

火山引擎总裁谭待指出,全球AI大模型正在三个方向上快速发展:一是深度思考模型正与多模态理解能力融合,二是视频、图像、语音模型逐步实现生产级水平,三是企业级复杂Agent正在走向成熟,为企业激发新的生产力潜能。

火山引擎总裁 谭待

豆包大模型1.6升级,国内首个原生支持“分档调节思考长度”的大模型

在服务大量企业用户的过程中,火山引擎发现,当开启深度思考模式,模型效果平均可提升31%,但会提高模型延迟和使用成本,这导致在实际应用中,深度思考模式的使用占比仅有18%。

针对这一痛点,豆包大模型1.6全新升级:提供Minimal、Low、Medium、High四种思考长度,平衡企业在不同场景下对模型效果、时延、成本的不同需求,并进一步提升了思考效率。这也是国内首个原生支持“分档调节思考长度”的模型。

以低思考长度为例,相比模型升级之前的单一思考模式,升级后的豆包1.6模型总输出tokens下降77.5%、思考时间下降84.6%,模型效果保持不变。

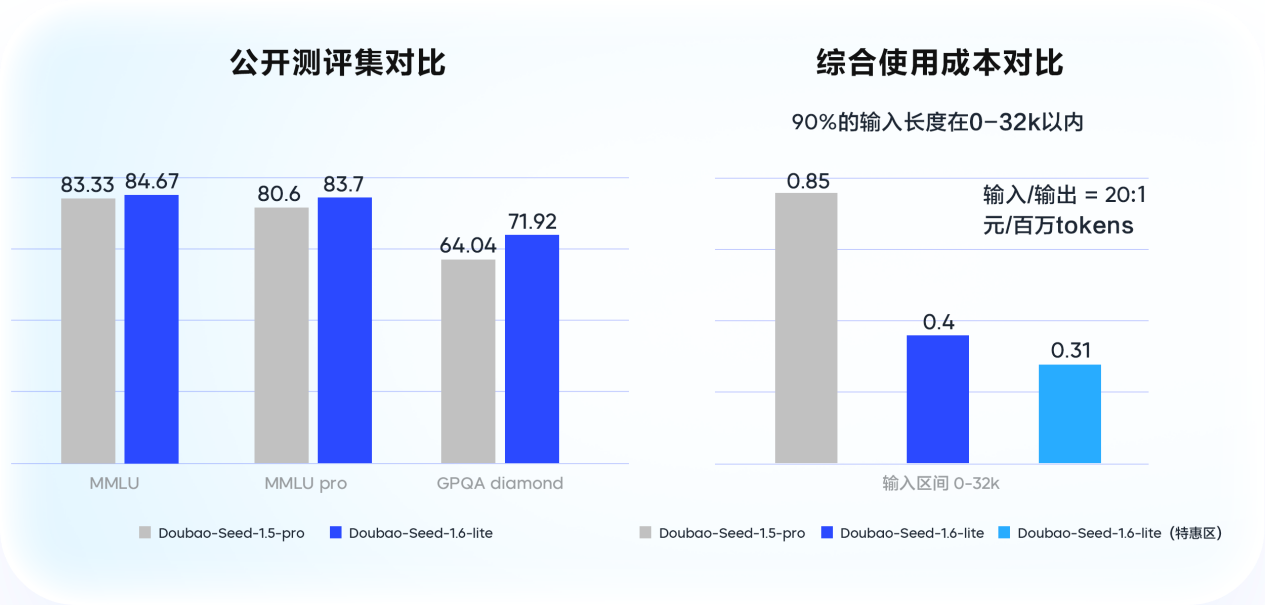

此外,为进一步满足企业的多样化需求,火山引擎正式推出豆包大模型1.6 lite,相比旗舰版本更轻量、推理速度更快。效果上,该模型超越豆包大模型1.5 pro,在企业级场景测评中较豆包1.5 pro提升14%;在使用量最大的0-32k输入区间里,综合使用成本较豆包1.5 pro降低53.3%。

豆包语音合成、声音复刻模型2.0发布,让声音能理解、会“表演”

巡展活动中,火山引擎正式发布豆包语音合成模型2.0(Doubao-Seed-TTS 2.0)、豆包声音复刻模型2.0(Doubao-Seed-ICL 2.0),具备更强的情感表现力、更精准的指令遵循能力,还能准确朗读复杂公式。

该模型基于豆包大语言模型研发语音合成新架构,让合成和复刻的声音都能进行深度语义理解,并拓展出上下文推理能力,从单纯的文本朗读进化为 “理解后的精准情感表达”。用户还能通过自然语言,实现对语速、情绪、声线、音调、风格变化的精准调整,大幅提升语音的可控性。

在教育场景中,复杂公式和符号的朗读一直是业界难题,目前市面上的同类模型朗读准确率普遍低于50%。新发布的两大语音模型进行了针对性优化,目前在小学至高中阶段全学科的复杂公式朗读中,准确率可达90%。

自去年5月首次发布以来,豆包语音模型家族已覆盖语音合成、语音识别、声音复刻、实时语音、同声传译、音乐创作、播客创作等7大领域,已覆盖超过4.6亿台智能终端。语音,正在成为AI应用的核心交互方式。

智能模型路由发布,国内首个模型智能选择解决方案

模型越来越多,面对具体需求时,如何选择模型最有性价比?

为了解决这个问题,火山引擎发布智能模型路由(Smart Model Router),这是国内首个针对模型智能选择的解决方案。即日起,用户可以在火山方舟上选择“智能模型路由”功能,该功能支持“平衡模式”、“效果优先模式”和“成本优先模式”三种方案,可针对任务请求自动选择最合适的模型,达到效果与成本的最优解。

目前,火山引擎智能模型路由已支持豆包大模型、DeepSeek、Qwen、Kimi等多种主流模型。以DeepSeek为例,经过实测,在效果优先模式下,智能路由后,模型效果相比直接使用DeepSeek-V3.1提升14%;在成本优先模式下,在实现DeepSeek-V3.1相似效果的条件下,模型的综合成本最高下降超过70%。

来源:数据猿

刷新相关文章

我要评论

不容错过的资讯

大家都在搜