1亿用户的ChatGPT老崩,7000万用户的文心一言却啥事没有?

原创 媛媛 | 2023-11-24 19:42

【数据猿导读】 根据百度三季度财报披露的数据,目前文心一言用户已经有7000万了。这是一个很大的体量。那么,有这样一个问题,文心一言怎么还没崩?以及,文心一言什么时候崩一次?

根据百度三季度财报披露的数据,目前文心一言用户已经有7000万了。这是一个很大的体量。

那么,有这样一个问题,文心一言怎么还没崩?以及,文心一言什么时候崩一次?

OpenAI经常被涌入的巨大用户量搞崩

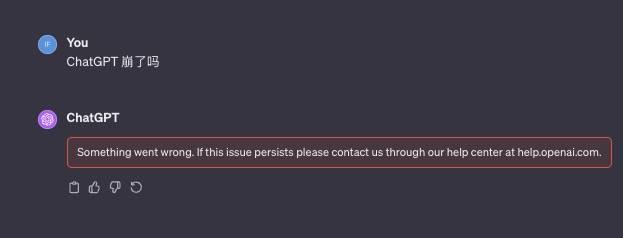

在讨论文心一言之前,作为一个对比存在,我们先来看看OpenAI的ChatGPT,在今年,ChatGPT经常被算力短缺困扰,动不动就崩一下。

最近,OpenAI举办了一场备受瞩目的展示活动,被戏称为“科技春晚”,向全球展示了其技术的最新成果,尤其是备受关注的明星产品ChatGPT。然而,这场热潮带来了一个巨大的挑战:用户数量的激增迅速超过了OpenAI的算力容量。

在大会结束后的短短两天内,ChatGPT服务器竟然崩溃,引发了一场用户无法正常使用ChatGPT和OpenAI提供的API的混乱。监控网站显示,北京时间11月8日晚上9点35分左右开始出现服务不可用的报告,到晚上10点报告数量达到峰值6773份。

面对这一危机,OpenAI做出了一个惊人的决定:暂停新的ChatGPT Plus用户的注册。OpenAI官方在21点54分宣布了服务问题,并在23点33分确认已经实施了修复措施,服务逐渐开始恢复。

ChatGPT的崩溃事件远不止如此。OpenAI于11月22日宣布,带语音功能的ChatGPT现在向所有用户免费开放。这意味着,用户现在可以使用手机进行语音对话。OpenAI在9月首次推出了通过语音和图像提示ChatGPT的功能,但当时仅对付费用户开放。

然而,不久之后,ChatGPT再次遭遇崩溃。在ChatGPT首页显示的信息中,称“我们正在经历异常高的需求,请耐心等待,我们正在努力扩大我们的系统”。这次事件引起了用户的不满和困扰,也让OpenAI面临了进一步提升其服务容量和稳定性的挑战。

ChatGPT老崩,但文心一言为什么挺住了?

要知道,ChatGPT的用户量也才刚刚破亿,而据百度财报披露,文心一言的用户量已经达到7000万了,两者之间差距是有,但已经非常接近。

那么,问题来了,为什么ChatGPT老崩,文心一言似乎还没爆出崩溃消息?

一个可能的原因是,虽然用户数量较为接近,但更为主要的是其用户使用频率、使用类型不一样,导致ChatGPT的单用户算力(尤其是GPU算力)消耗量,要高于文心一言。

调查机构 Writerbuddy.ai 使用 SEMrush 工具,分析了2022年9月至2023年8月期间,用户访问各家AI工具的流量情况。

根据调查结果显示,排名前50名的AI工具在这10个月中累计被访问240亿次,而其中ChatGPT达到了惊人的146亿次,占比超过60%,平均每月访问15亿次。

虽然文心一言的用户量达到了7000万,但其用户流量可能比ChatGPT还是要小不少。这也许可以解释ChatGPT总被巨大的用户量带崩,但文心一言却安然无恙。

当然,还有另外一种可能性,那就是OpenAI是创业公司,其云算力资源不足,但文心一言诞生于百度,本身就有百度云加持,算力资源比OpenAI更强,可以支撑更高的用户量。

但是,ChatGPT虽然是创业公司,但却是明星创业公司,并且得到了微软云的全力支持,其能够调动的算力资源应该不亚于文心一言才对。据了解,微软的Azure云服务为ChatGPT构建了上万枚英伟达A100 GPU芯片的AI计算集群。

在算力资源尤其是GPU算力资源方面,OpenAI在全球来看应该都是顶级的。

在全球GPU领域中,英伟达是霸主。因为美国政策限制,中国市场获取英伟达GPU还存在障碍。从这个角度来说,ChatGPT的GPU算力资源,应该要强于文心一言。

算力资源,是大模型商用必不可少的“粮草”

无论是什么原因,文心一言现在还能够撑得住7000万的用户量,都是一件值得恭喜的事。

然而,我们还不可以掉以轻心。

未来,文心一言、通义千问、讯飞星火、智谱清言等,大概率会出现数亿用户的国民级APP。而且,除了C端用户外,大模型还通过行业大模型的方式,在B端快速落地。

B端的算力需求可能会超过C端,因为商业应用通常涉及更复杂的数据处理和分析任务。例如,在金融行业,AI模型需要处理大量的交易数据和市场趋势,来进行预测和风险评估;在医疗领域,模型需要分析复杂的医学图像和患者历史记录,来辅助诊断和治疗计划。

以我们目前的算力基础设施情况,能否撑得住如此大规模的使用需求,还需要打上一个大大的问号。

当然,有人会说,现在几亿用户的APP还少么,微信、淘宝、拼多多、抖音、美团、百度等,哪一个不是有数亿用户?那文心一言、通义千问等大模型APP,有几亿用户不也很正常么?

事情并没有那么简单。

例如,同样都是几亿用户,百度APP和文心一言所产生的算力需求是完全不一样的。以往的移动互联网应用,主要消耗的是CPU资源,而大模型应用却是消耗GPU资源。

目前,无论是手机终端还是云端的服务器,CPU资源都比较充足。但是GPU作为一项新兴技术,无论是技术成熟度还是资源储备,都还不能很好的支撑大规模的AI应用。建设100万个CPU计算集群已经不难了,但是建设100万个GPU计算集群,却是非常困难且成本巨大的事情。

可以预见,当文心一言有几亿用户,并且用户的使用频率较高,文心一言还接入BI、CRM、客服、营销等各个业务系统,那肯定会带来极大的AI算力需求,百度云能不能撑得住,是需要打一个大大的问号的。也许,百度在不久的将来,也会品尝一下OpenAI那样的“甜蜜的负担”——业务量太大,系统撑不住,时不时崩一下。

文心一言、通义千问的大规模商用预示着一个新时代:AI大模型的统治。但这背后隐藏着一个巨大的算力危机:高性能GPU资源,当前AI应用的命脉,正面临严重短缺。

这不仅是供应问题,还是成本问题。我们正在进入一个新阶段,其中AI的饥渴对算力的需求与现实的供应能力严重脱节。

云计算和分布式计算虽提供了一线希望,但这远非万全之策。算法优化和模型精简,这听起来美好,但实际上是一场与时间赛跑的挑战。长远来看,新兴技术如量子计算可能成为救星,但远水解不了近渴。

当前的核心问题,是高性能GPU的供应紧张和成本高昂。虽然GPU技术正在快速发展,但其创新速度可能跟不上这些应用日益增长的需求。此外,运行这些大型计算集群需要大量电力,这也意味着巨大的成本支出。

大模型为我们打开了一扇通往AI的大门,但要走好这条路,还有很都问题需要解决。

文:媛媛 / 数据猿

来源:数据猿

刷新相关文章

我要评论

不容错过的资讯

大家都在搜