理想汽车的雷达在无人陵园内看到鬼?网友:按一下喇叭看会不会聚过来!

原创 一蓑烟雨 | 2023-03-31 11:07

【数据猿导读】 一般而言,科学与鬼神是毫不沾边的。但是,在自动驾驶领域,他们却产生了联系。 日前,一位辽宁沈阳的理想汽车车主在社交媒体发布视频称,自己的理想L9在空无一人的陵园道路上识别并标注出了数位行人。据悉,该车主在陵园祭祖,发现园区没人,汽车雷达却显示全是人,不仅有走路的还有...

一般而言,科学与鬼神是毫不沾边的。但是,在自动驾驶领域,他们却产生了联系。

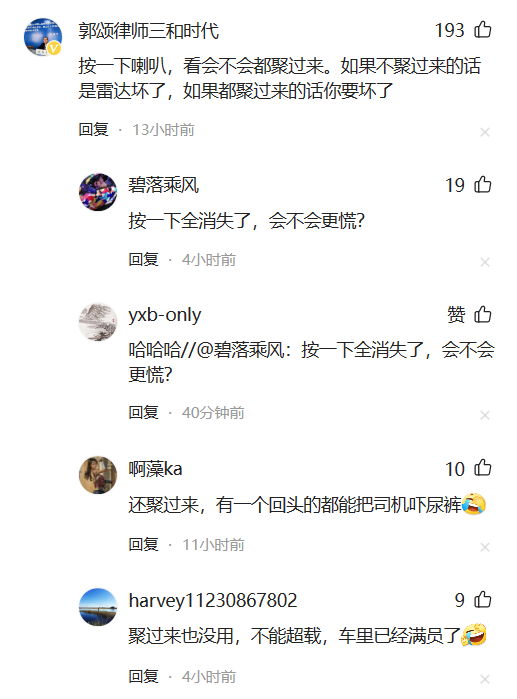

日前,一位辽宁沈阳的理想汽车车主在社交媒体发布视频称,自己的理想L9在空无一人的陵园道路上识别并标注出了数位行人。据悉,该车主在陵园祭祖,发现园区没人,汽车雷达却显示全是人,不仅有走路的还有骑自行车的。

该事件也引起了网友的热议。

很快,理想汽车方面就此作出了回应,“理想Max系列车型,使用激光雷达和视觉摄像头融合感知,受限于当前市场上传感器识别能力的局限性,车辆在某些场景下会出现显示异常,我们会在后续的OTA优化算法来加强识别能力。”

这已经不是理想汽车第一次出现灵异事件了,1月15日,上海浦东的一位理想汽车车主,就称其夜间驾车出行,中控屏突然显示有人在后方追车,检查后发现车后并没有人。

事实上,“看到鬼”这个技能并不是理想汽车独有的,特斯拉车主很早就爆料过类似的事情。

2021年7月,成都的一位特斯拉车主爆料,他的特斯拉在凌晨一两点的成都酒店地下停车场里“抓到了鬼”。这位车主凌晨一两点下楼准备开车走人,坐上车启动后,车辆显示“左侧有人”,然而车主一眼望去,什么都没有。

更早时期,一名外国网友在Tiktok上发视频称,自己驾驶特斯拉行经无人墓地,特斯拉却感应出了很多行人,此举引发不少网友跟帖,表示自己的特斯拉在无人街道也曾感应出行人。

2021年7月,一位特斯拉车主在美国纽约市的曼哈顿区驾驶时,他的特斯拉车载摄像头记录下了一段视频,视频中显示了一个看起来像是人的物体从车辆前方快速闪过。但是,该车主表示,当时他的车辆附近没有任何人或物。

2019年4月,一位特斯拉车主在新加坡的高速公路上行驶时,他的特斯拉车载摄像头记录下了一段视频,视频中出现了一个模糊的人影。但是,该车主表示,当时他的车辆附近没有任何人或物。

还有更“邪门”的,有些特斯拉车主爆料,他们的特斯拉汽车曾被“幽灵”控制过:

2020年5月,一位特斯拉车主在华盛顿州的公路上行驶时,他的特斯拉突然加速,并在高速公路上冲向障碍物。这位车主认为,他的特斯拉被“鬼魂”或其他超自然力量控制。

2019年9月,一位特斯拉车主在美国加利福尼亚州的公路上行驶时,他的特斯拉突然启动了紧急刹车系统,导致车辆突然停止。这位车主认为,他的特斯拉被幽灵控制。

2019年4月,一位特斯拉车主在美国佛罗里达州的公路上行驶时,他的特斯拉突然加速并撞上了一堵墙。这位车主认为,他的特斯拉被幽灵控制。

作为一个科技媒体,我们当然不相信理想、特斯拉汽车真的可以“看到鬼”。但是,这样的灵异事件一再出现,到底是什么原因导致的呢?

接下来,我们试图从科学角度来剖析一下自动驾驶汽车的摄像头、雷达能够感知到“鬼影”的原理。

自动驾驶汽车的摄像头和雷达是通过使用传感器技术进行感知和感知环境的。这些传感器可以检测周围的物体、行人、车辆等,并通过对这些物体的分析来识别它们的位置、速度、方向和距离等信息。但是,即使这些传感器非常先进和精确,也可能会出现错误的情况,导致汽车看到不存在的人或物体。

一种可能的原因是传感器在进行感知时受到环境因素的干扰,例如强烈的阳光、阴影、雨雪等天气条件可能会影响摄像头和雷达的精度。此外,路面上的反射和折射也可能会导致传感器的感知误差。

另一个原因是传感器的算法和软件可能存在漏洞,这些漏洞可能会导致传感器错误地识别物体的位置或速度等信息。例如,某些算法可能会将道路上的标志牌或路缘石等物体错误地识别为行人或车辆。

可以发现,一辆自动驾驶汽车的感知、决策核心主要包括三个方面,分别是传感器、AI算法、软件系统。

接下来,我们来更深入分析传感器、算法、软件的工作原理,并在此基础上来推测一下哪些环节可能出现问题,导致了上面提到的看到鬼影这样的灵异事件。

先来看看传感器。

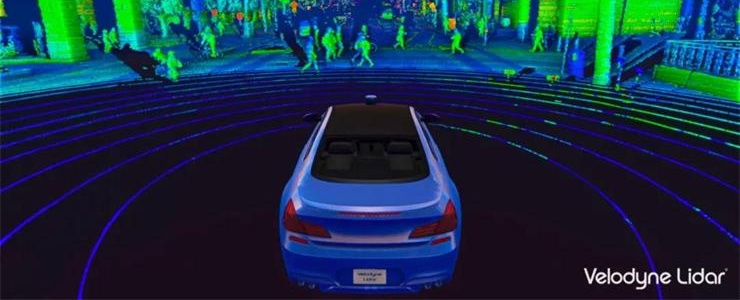

传感器方面:

自动驾驶汽车一般会使用多种传感器来感知周围环境,主要包括以下几种:

摄像头:它们可以通过采集视频流来感知环境中的物体和场景。一般而言,摄像头会使用计算机视觉算法来分析视频流中的图像,并从中提取出目标物体的位置、速度和方向等信息。

雷达:雷达利用电磁波来感知物体,其原理是向物体发射电磁波,并通过接收反射回来的波来测量物体的位置、速度和方向等信息。雷达一般可以工作在不同的频率范围内,包括毫米波和厘米波等。

激光雷达:激光雷达使用激光束来扫描周围的环境,其原理是通过测量激光束反射回来的时间和强度来测量物体的位置和形状等信息。激光雷达一般具有很高的精度和分辨率。

那么,在看到鬼影这件事情上,传感器可能会扮演什么角色呢?

一般而言,传感器出现错误的可能情况主要是以下几种:

环境干扰:例如,强烈的阳光或者阴影、雨雪等天气条件会影响传感器的精度。此外,道路上的反射和折射也可能会导致传感器的感知误差。

感知误差:例如,由于传感器的分辨率限制,小型或者远距离的物体可能无法被正确地识别。此外,传感器的盲区、视野范围等也可能导致识别错误。

感知器件故障:例如,传感器的元器件(例如镜头、探头等)损坏、偏移或者失灵等也可能导致感知误差。

一言以蔽之,光线、雨雪等因素影响,可能会让自动驾驶的各类传感器“看花眼”。事实上,在强光、黑夜、大雾、暴雨等恶劣环境下,人类也可能会看花眼。人眼睛会犯的错误,自动驾驶汽车的摄像头、雷达等传感器也完全有可能犯。

传感器是硬件,接下来,我们再继续从算法、软件角度来找找原因。

自动驾驶汽车的检测与识别技术是其实现自主导航的关键,要分析为什么汽车感知系统能够“看到鬼”,最关键的就是要从检测与识别技术上找原因。

现代自动驾驶汽车通常采用多种传感器来感知周围环境,包括摄像头、雷达、激光雷达、超声波传感器等。这些传感器获取到的数据需要通过算法和软件进行处理,才能提取出有用的信息。

在检测与识别技术中,常用的算法包括了神经网络、卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)、支持向量机(Support Vector Machine,SVM)等。

以摄像头为例,它可以采集到道路、交通标志、车辆、行人等物体的图像信息。对这些图像信息进行处理的核心算法是卷积神经网络(CNN)。CNN通过多层卷积和池化操作来提取特征,并将这些特征输入到全连接层中进行分类。这种算法在图像分类和目标检测中表现优秀。常用的卷积神经网络结构包括了AlexNet、VGG、GoogLeNet、ResNet等。

除了图像信息,雷达、激光雷达等传感器可以提供目标的距离和速度信息。这些信息可以通过雷达信号处理算法进行处理。常用的雷达信号处理算法包括了峰值检测、脉冲压缩、距离滤波、速度滤波、多普勒处理等。

在识别行人等物体时,循环神经网络(RNN)也经常被应用。RNN是一种能够处理序列数据的神经网络,它可以在输入序列中保留历史信息,并进行预测。在行人检测中,RNN可以用来预测行人的位置和行走方向。当然,除了算法,软件也是实现自动驾驶汽车检测与识别技术的重要组成部分。常用的软件包括了OpenCV、TensorFlow、Caffe等。

搞清楚了自动驾驶的一些核心算法,接下来我们就来推测一下可能是在哪些算法或者环节上出现问题,导致汽车看到鬼。

一般而言,可能会存在以下一些问题导致自动驾驶汽车“看到”不存在的人:

意外目标检测错误:自动驾驶汽车中常用的目标检测算法包括RCNN、YOLO、SSD等,这些算法都需要在训练时输入大量的标注数据来训练模型,以便在行驶过程中识别路面上的行人、车辆、交通信号灯等目标。然而,在标注数据中可能存在一些错误标注或者遗漏的情况,这些问题可能会导致算法出现误判。例如,如果训练数据中没有正确标注人行道或者人行横道,那么当自动驾驶汽车遇到这种情况时,就可能会将路面上的其他物体(如路边的灌木丛、垃圾桶等)误认为是人或者人群。

深度学习模型框架问题:深度学习模型是目标检测算法的重要组成部分,它是一种通过多层神经网络来学习和提取特征的机器学习算法。深度学习模型的训练数据集和模型架构对其性能至关重要。如果训练数据集中缺乏一些场景的数据,或者模型架构没有设计好,就有可能导致自动驾驶汽车误判。例如,如果训练数据集中缺乏夜间行人的数据,那么模型在夜间可能会误将一些不存在的物体视为行人。

多传感器数据融合错误:自动驾驶汽车中采用了多种不同类型的传感器,如相机、雷达、激光雷达等,它们可以获取不同类型的信息。为了更好地感知环境,需要将不同传感器获取的信息进行融合。如果融合算法存在缺陷,就可能会导致误判。例如,如果车辆传感器融合算法没有考虑到相机和雷达在低光照下的不同表现,就可能导致相机误将一些不存在的物体视为行人。

获取信息不完整:自动驾驶汽车感知环境时,其传感器获取到的信息不足以完整地描述周围环境和目标物体的特征,导致识别出现错误。具体来说,当传感器获取的图像、雷达或者激光雷达数据不完整时,自动驾驶汽车可能会误认为周围环境中存在不真实的障碍物体,包括行人、车辆、道路设施等,这就可能导致出现“看到”不存在的人的错误。

举个例子,假设自动驾驶汽车正在行驶在城市中的一条街道上,该街道上人流量较大。此时,一辆自动驾驶汽车的摄像头可能会误认为路边的一棵树或灯柱等为一个人,因为它们的形状或颜色可能与行人相似。此时,算法可能会根据前面介绍的模型对图像进行分析,并将图像中的物体进行分类。由于前后文信息不完整,算法可能会将这个“看似”行人的物体误分类为人。这样,系统会将一个不存在的人物添加到它的感知系统中,这就是一个错误的判断。如果车辆没有及时纠正这个错误,可能会导致安全风险。。

综上所述,自动驾驶汽车“看到”不存在的人这个问题可能涉及到多个算法和软件的问题。其中,目标检测算法、深度学习模型和车辆传感器融合算法是可能出问题的关键点。如果算法或者软件出现缺陷,就可能导致自动驾驶汽车误判,将一些不存在的物体视为行人或车辆。

正如历史上的诸多灵异事件最终都能找到一个科学解释一样,自动驾驶汽车看到鬼这个事情,也可以从技术角度找到一些原因。更关键的是,我们可以从技术角度来进行优化,找到问题并解决问题,避免类似的错误再次发生。

可以预见,通过传感器、算法、软件层面的优化,以后的自动驾驶汽车“看到鬼”这个问题将得到有效的解决。

还是需要相信科学!

文:一蓑烟雨 / 数据猿

来源:数据猿

我要评论

不容错过的资讯

大家都在搜